Uma das ferramentas que mais ganham aderência e popularidade no mercado de TI está relacionada com a orquestração de containers em nuvem e com o desenvolvimento consistente da infraestrutura de cloud computing nas empresas. Já ouviu falar de orquestração de containers por meio de Kubernetes?

Esse sistema representa uma peça-chave no portfólio de qualquer profissional da TI moderna, por causa da sua popularização para atender à demanda de cada vez mais aplicações nativas e modernas em nuvem.

De maneira geral, podemos dizer que o Kubernetes – também conhecido como K8s – é um sistema de código aberto (open-source) para automatizar a implantação, o escalonamento e o gerenciamento de aplicativos containerizados.

Dessa forma, o Kubernetes representa uma das principais soluções de orquestração de container, originalmente, desenvolvidas pelo Google, mas que hoje é mantido pela Cloud Native Computing Foundation.

Por entender a importância do tema, separamos, neste guia, os principais pontos acerca dessa tecnologia. Leia conosco!

- Necessidades das organizações modernas.

- O que são containers e quais são as suas diferenças em relação à VMs?

- O que é orquestração de containers e quais problemas ela visa resolver?

- Como escolher entre serviços gerenciados de Kubernetes e implantação do próprio cluster.

- 5 exemplos de provedores de Kubernetes.

Necessidades das organizações modernas

O crescimento da tecnologia da orquestração de containers Kubernetes ocorre no contexto de uma grande migração de workloads para ambientes de cloud. Essa demanda por clouds – públicas, privadas ou híbridas – representa uma transformação significativa no panorama da TI, que prioriza investimento em ambientes da nuvem e também no paradigma de desenvolvimento de aplicações.

É cada vez mais interessante às organizações que exista uma preocupação com a portabilidade e com a capacidade de se evitar o vendor lock-in. Além disso, pela maior hibridização dos métodos de implantação dos servidores, os negócios precisam se adaptar sempre de forma rápida aos cenários heterogêneos. Somado a isso, as empresas ainda enfrentam um ambiente de negócios altamente competitivo e dinâmico, que exige inovações constantes e novas aplicações com mais rapidez e eficiência.

Tudo isso requer um ambiente de TI ágil e escalável, que possa suportar a implantação de novas aplicações em uma variedade de ambientes de nuvem. É nesse contexto que a orquestração de containers com Kubernetes se torna uma necessidade para as organizações atuais, permitindo que os negócios implementem aplicações de forma mais rápida e eficiente e reduzam o time to market.

A tecnologia também é capaz de assegurar que as organizações gerenciem e escalonem as suas aplicações de forma mais eficiente, tendo a alta disponibilidade para os usuários finais como um diferencial-chave.

O Kubernetes oferece recursos avançados de gerenciamento de múltiplos clusters, que asseguram que as organizações implantem e administrem aplicações de forma consistente em todos os ambientes cloud.

O que são containers e quais as suas diferenças em relação à VMs?

Os containers, popularizados pelo Docker (2013), são uma unidade-padrão de software com artefatos leves e que contêm políticas de segurança e isolamento próprias, além de código-fonte e todas as dependências necessárias para operar de forma rápida e confiável nos mais diversos ambientes, sejam eles de desenvolvimento, homologação ou produção.

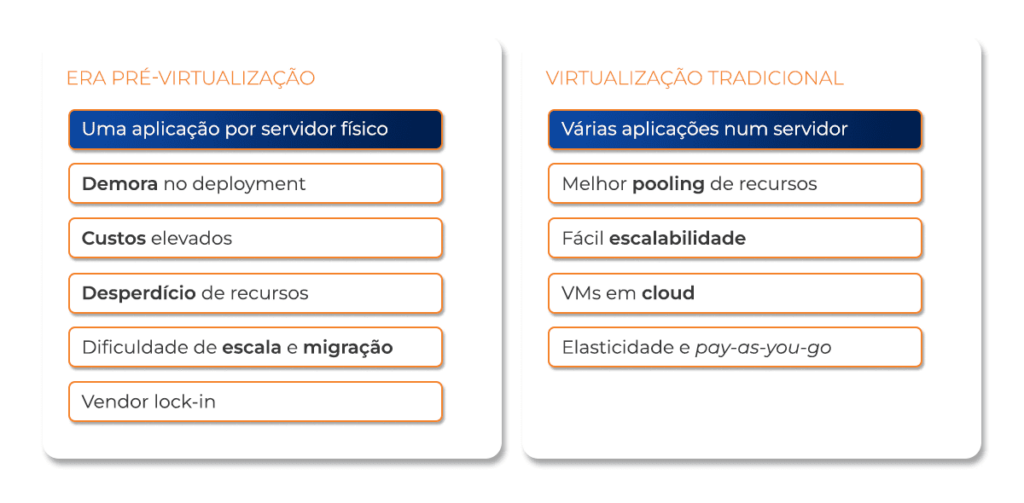

Essa tecnologia se diferencia das demais máquinas virtuais (VMs) e das práticas de virtualização tradicionais por ser uma alternativa menos “pesada”, com artefato em nível de aplicação, e não mais em nível de infraestrutura.

Na virtualização tradicional, é comum encontrar algumas desvantagens, como a VM Sprawl (expansão ou proliferação de VMs) e a necessidade de limpeza dessa multiplicação de máquinas. Quando ocorre esse problema, por causa da criação de máquinas virtuais sem um planejamento adequado, há sobrecarga dos recursos do servidor físico e, possivelmente, queda no desempenho do sistema, aumento da latência ou até mesmo falhas.

Outro desafio da virtualização tradicional pode estar alocado na redundância de recursos, uma vez que algumas operações podem ser duplicadas sem necessidade, algo que também sobrecarrega o sistema. Além disso, há a ocorrência de falhas na sincronicidade de portabilidade entre ambientes e bibliotecas. Às vezes, quando uma aplicação é movida de um ambiente virtual para outro, bibliotecas ou outras dependências necessárias para que ela funcione adequadamente não estão integralmente disponíveis ou são diferentes no novo ambiente. Com isso, a compatibilidade é comprometida e pode afetar o funcionamento correto da aplicação.

Por outro lado, nos containers, o kernel e os recursos básicos são compartilhados, mesmo que estejam rodando diferentes aplicações, o que leva a benefícios como:

- Mais velocidade na inicialização;

- Menor footprint de memória;

- Racionalização no uso de recursos;

- Mais instâncias por unidade de hardware.

Ainda assim, como em qualquer outra estratégia de virtualização, essa também possui desafios:

- Aplicações conteinerizadas podem ter muitas dependências, o que gera serviços complexos;

- A configuração e a alocação de contêineres ficam bem prejudicadas com o crescimento do parque;

- O balanceamento de carga e a publicação de aplicações devem ser tratados;

- O monitoramento e a self-healing de aplicações devem ser gerenciados;

- O ambiente deve ser capaz de escalar à medida que a demanda aumenta;

- As interações intercontainers devem ser configuradas de forma segura.

Dessa maneira, uma das principais diferenças entre a conteinerização e as VMs se dá na esfera da gerência. Os containers podem ser administrados por meio de ferramentas de orquestração, como o Kubernetes, que permite implantar, escalar e monitorar vários deles ao mesmo tempo, enquanto as VMs exigem uma abordagem mais tradicional de gerenciamento, que envolve a alocação de recursos de hardware para cada uma delas.

O que é orquestração de containers e que problemas ela visa resolver?

A orquestração de containers é um processo de gerenciamento automatizado que inclui o provisionamento, a implantação, o escalonamento e o monitoramento de vários containers. A atividade é realizada por meio de ferramentas de gerenciamento de containers, como o Kubernetes, que ajudam as organizações a automatizá-los e gerenciá-los de forma mais eficiente. O objetivo da orquestração é resolver problemas que surgem quando as organizações começam a utilizar containers em escala, como os elencados a seguir:

- Provisionamento – o Kubernetes permite que o profissional de TI defina um conjunto de recursos de infraestrutura, especificando que configuração será implantada para as aplicações. Em outras palavras, significa dizer que essa prática faz o provisionamento automático da infraestrutura necessária e, assim, implanta os containers de acordo com as especificações definidas. Quando o provisionamento é manual, esse processo demanda conhecimento avançado de tecnologia de containers, é mais demorado e passível, claro, de falhas humanas.

- Implantação – assim como na funcionalidade anterior, a orquestração de containers por Kubernetes consegue driblar o problema da implantação manual por ser capaz de automatizar o processo, com a utilização de estratégias de implantação para facilitar sua atualização e a oferta de recursos avançados de gerenciamento de configuração e segredos.

Com o Kubernetes, há a definição de um conjunto de especificações que descrevem como as aplicações devem ser implantadas, como informações da imagem do container, quantidade de réplicas e configurações de rede e armazenamento.

Com isso, a própria ferramenta implanta os containers de forma automática, executa uma estratégia que facilita a atualização dessas aplicações sempre que uma nova versão é utilizada e monitora seu progresso. Essas ações, realizadas de maneira automática, otimizam o problema da disponibilidade das aplicações durante a atualização.

- Escalonamento – o Kubernetes permite a definição de políticas de escalonamento que possibilitam que a infraestrutura seja escalonada automaticamente para acomodar picos de demanda ou, quando for o caso, reduzir o uso de recursos em períodos mais tranquilos.

Além disso, o escalonamento se torna mais eficiente com essa tecnologia, uma vez que ela executa um balanceamento de cargas e distribui os containers de maneira estratégica entre os nós dessa infraestrutura. Por meio do gerenciamento de recursos, a infraestrutura ainda é administrada sob uma ótica de maximização da eficiência e redução do desperdício de atributos.

- Monitoramento – há recursos no Kubernetes que dão ao usuário a capacidade de supervisionar a saúde dos clusters em tempo real e integrar outras ferramentas de monitoramento nesse processo. Com isso, é possível coletar métricas de desempenho e estado dos containers e serviços em execução e exibir esses dados em painéis personalizados.

Dessa forma, o processo de observação do funcionamento dos sistemas e das aplicações se torna mais efetivo e pode, inclusive, ser configurado para exibição de alertas e notificações dos usuários quando alguma intercorrência afetar a estrutura.

Veja também o webinar gratuito “Como a orquestração de containers com Kubernetes pode ajudar minha organização?”

______________________________________

Entre os outros diferenciais da tecnologia, a orquestração de containers ainda permite que as organizações os gerenciem em escala, garantindo que as aplicações estejam disponíveis para os usuários finais o tempo todo. Também garante que as organizações implantem aplicações em múltiplos ambientes de nuvem, incluindo nuvens públicas, privadas e híbridas, o que torna a orquestração de containers essencial para as empresas que buscam uma estratégia de nuvem escalável e eficaz. Ou seja, o potencial de escalabilidade da virtualização por meio de containers e de Kubernetes é o que destaca essa tecnologia no mercado.

Por ser uma plataforma de código aberto mantida pela Cloud Native Computing Foundation (CNCF), há uma grande comunidade de desenvolvedores e usuários, o que significa que há boa quantidade de recursos disponíveis para ajudar as organizações a adotar e implementar o Kubernetes.

Embora a tecnologia também encontre desafios que precisam ser superados dia a dia pelo profissional de TI, ela representa uma solução eficaz para gerenciar containers em escala nos ambientes de nuvem.

Como escolher entre serviços gerenciados de Kubernetes ou a implantação do próprio cluster

A escolha entre um serviço gerenciado de Kubernetes ou a implantação do próprio cluster depende de diversos fatores, incluindo a experiência da equipe. Para esse caso, é necessário que o time compreenda que o gerenciamento de cluster Kubernetes é a forma pela qual uma equipe de TI é capaz de administrar estrategicamente um grupo de clusters do Kubernetes, ou seja, deter o conhecimento acerca de vários deles e fazer com que esse sistema performe no melhor ao pior dos cenários. Além disso, antes de tomar essa decisão, os gestores precisam refletir sobre os requisitos de recursos, a complexidade do projeto, os custos e os objetivos de negócio.

Listamos, a seguir, alguns pontos a serem considerados para ajudar nessa decisão.

1) Experiência e conhecimento

Serviço gerenciado: se a equipe não possui muita experiência com Kubernetes, um serviço gerenciado pode ser uma escolha mais vantajosa, pois muitas tarefas de manutenção e administração são tratadas pelo provedor.

Implantação própria: se você tem uma equipe experiente em Kubernetes e está confortável com a configuração, implantação e manutenção de clusters, então implantar o próprio cluster pode ser uma opção.

2) Complexidade do projeto

Serviço gerenciado: para projetos menores ou de médio porte, um serviço gerenciado pode ser mais simples de configurar e gerenciar.

Implantação própria: para projetos mais complexos ou personalizados, em que você precisa de controle total sobre a configuração do cluster, a implantação própria pode ser mais adequada.

3) Recursos financeiros

Serviço gerenciado: normalmente, serviços gerenciados envolvem um custo mensal, mas podem ser mais econômicos para equipes que não têm recursos para manter infraestrutura própria.

Implantação própria: implantação própria pode ser mais custosa em termos de tempo, pessoal e recursos financeiros. É necessário considerar os custos de hardware, largura de banda e energia, além do tempo investido pela equipe.

De maneira geral, essa análise está diretamente ligada à existência prévia ou não de infraestrutura na organização-alvo, sendo uma condição importante para a decisão de infraestrutura gerenciada ou self managed.

4) Manutenção e atualizações

Serviço gerenciado: atualizações e patches são, geralmente, tratados pelo provedor, o que reflete na redução da carga de trabalho operacional da equipe.

Implantação própria: manutenção e atualizações ficam sob responsabilidade da equipe, o que pode demandar mais tempo e recursos.

5) Conformidade e segurança

Serviço gerenciado: alguns serviços gerenciados oferecem recursos de segurança e conformidade integrados, sendo importantes para projetos que lidam com dados sensíveis e têm dificuldade em se adaptar às regulamentações desses quesitos.

Implantação própria: há maior controle e gerência sobre as medidas de segurança, permitindo uma atuação personalizada, de acordo com os requisitos específicos. A carga gerencial nesses casos é significativa, portanto, é realmente um ponto em que a opção por serviços gerenciados se torna muito mais simples em termos de implantação.

A opção por essa modalidade vai variar de acordo com a experiência das equipes e a disponibilidade de recursos e capital, bem como as especificidades de cada projeto.

Cinco exemplos de provedores de serviços Kubernetes

1) Amazon Kubernetes

Também chamado Amazon Elastic Kubernetes Service (EKS), esse serviço se diferencia por permitir a execução, a iniciação e o dimensionamento de aplicativos Kubernetes na nuvem AWS e também localmente. O Amazon EKS substitui, gradualmente, o ECS, além de automatizar tarefas importantes de gerenciamento do Kubernete, como provisionamento de nós, aplicação de patches e atualizações:

- Criptografia e segurança embutida;

- Integração com o CloudWatch para registro;

- Atualização automática.

- IAM para permissões de acesso e CloudTrail para auditoria.

2) Docker Enterprise

Embora a Docker Enterprise tenha sido adquirida pela Mirantis, empresa especializada em serviços K8s e Open Stack, o produto de código aberto continuou com a Docker Inc. Ainda assim, a Mirantis lançou atualizações importantes para o produto, mantendo o nome Docker Enterprise. Tais inovações objetivam auxiliar o recurso a competir melhor com os principais players de nuvem híbrida:

- Permite executar orquestradores Swarm e Kubernetes no mesmo cluster;

- Integra várias ferramentas de código aberto ao Docker e ao Lens;

- Analisa e visualiza o código rapidamente em um ou até vários clusters.

3) Google Kubernetes

Caracterizado por ser o primeiro serviço de Kubernetes baseado em nuvem do mercado, o Google Kubernetes Engine é um ambiente gerenciado para escalonamento, implantação e administração de aplicativos em contêineres em uma infraestrutura segura do Google.

Considerado uma das plataformas disponíveis mais avançadas de Kubernetes, o Google Kubernetes Engine, atualmente, chama a atenção por alguns pontos de destaque:

- Facilita a criação de clusters;

- Possui recursos avançados de gerenciamento de cluster;

- Realiza escalonamento automático;

- Faz balanceamento de carga;

- Executa reparos e upgrades automáticos;

- Trabalha com registro e monitoramento.

4) IBM Kubernetes

Disponível, desde 2017, como IBM Cloud Container Service, representa uma das primeiras ofertas Kubernetes gerenciadas totalmente na nuvem. No ano seguinte, foi renomeada IBM Cloud Kubernetes Service como forma de marcar o investimento estratégico da gigante no Kubernetes e também registrar que ela é fundadora do CNCF K8s Conformance Testing.

Entre suas características, estão:

- Possibilidade de criação de clusters Kubernetes para gerenciar e implementar aplicativos em contêineres na IBM Cloud;

- Recursos nativos do Kubernetes, como autocorreção, programação inteligente, descoberta de serviço, escalonamento horizontal, implementações e reversões automatizadas, balanceamento de carga e gerenciamento de configurações e segredos.

5) Oracle Container Engine for Kubernetes

Este é um serviço totalmente gerenciado, que pode ser utilizado para a criação de clusters Kubernetes, por meio de um console baseado em navegador e também APIs REST. Possui como diferenciais:

- Interação de clusters usando Kubernetes Dashboard, Kubernetes API e utilitário de linha de comando Kubernetes (kubectl);

- Gerenciamento e implantação automatizados desses aplicativos em contêiner;

- Todos os serviços podem ser integrados ao Identity and Access Management (IAM) para autorização e autenticação;

- O OKE pode ser integrado ao Wercker, que é uma plataforma de entrega contínua baseada em Docker.

Além desses, outros serviços são bem conhecidos para essa finalidade, como Rancher, Alibaba Kubernetes, Linode Kubernetes, DigitalOcean Kubernetes e Azure Kubernetes.

____________________________________________________________

Dominar o conhecimento da tecnologia de conteinerização por meio de Kubernetes e também do gerenciamento de clusters de Kubernetes inaugura um nicho de atuação no mercado de TI cada vez mais necessário e popular.

Aposte no seu futuro neste setor: inscreva-se no curso EaD da ESR “Orquestração de containers com Kubernetes”